提高 Google Play 上 A/B 测试的可靠性

本文也在 2020 年 5 月 13 日的 ASO 在线会议上进行了介绍。

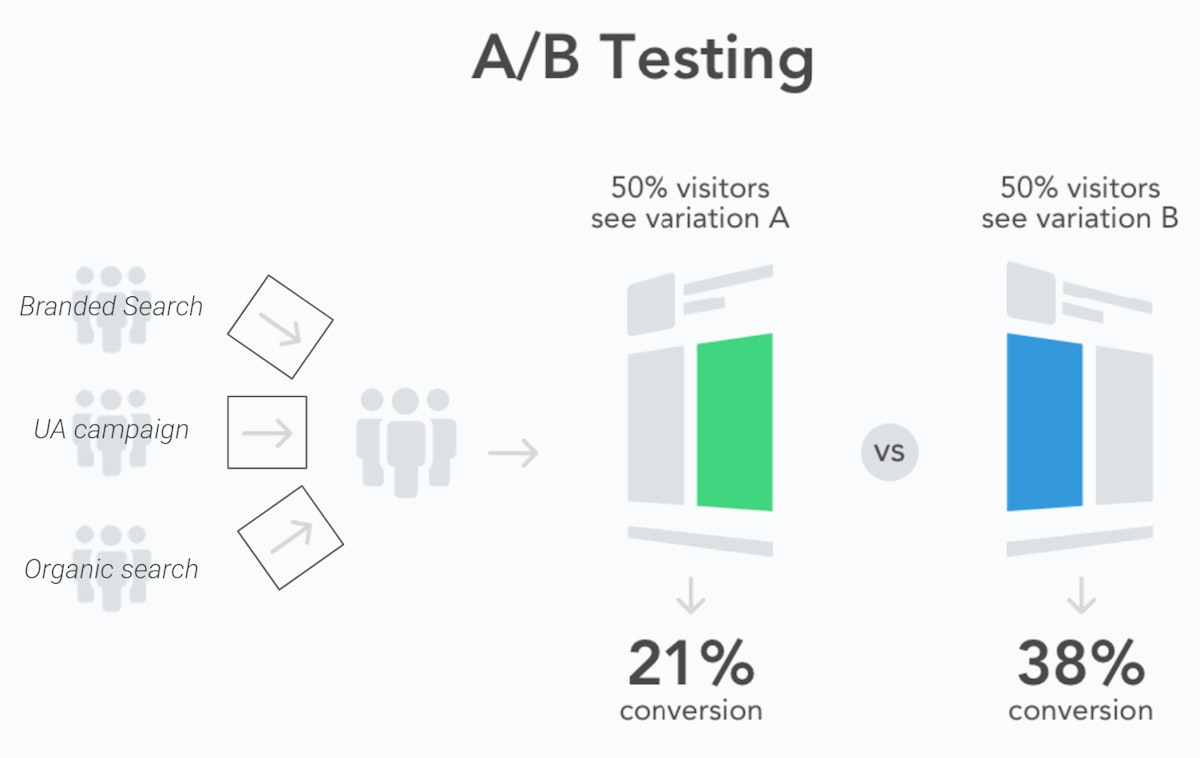

A/B 测试已成为移动营销中的标准做法,ASO 也不例外。其原理很简单:

- 将受众分成不同的样本

- 向他们展示不同的变体(例如,不同的截图组合)

- 测量每个变体的表现,根据数据而非个人喜好来决定使用哪一个

问题在于,测试结果的可靠性取决于测试本身。虽然 Google Play 有一些主要优势,如在原生环境中运行测试,但许多 ASO 从业者发现,当他们将获胜变体应用于 100% 的用户时,工具预测的转化提升并未实现。这些结果被称为

Google Play A/B 测试中的”统计噪音”

Google Play 结果中假阳性的主要原因之一是测试样本的构建方式。由于 Google Play 商店实验结果缺乏数据细分,Google 的 A/B 测试工具可能无法区分不同类型的用户。这可能会在测试样本的转化率中造成显著的不平衡,因为访问您应用商店页面的用户有不同的意图:

- 搜索您品牌的用户由于认知度高,可能会很快下载您的应用。

- 来自广告活动或通用搜索的用户可能需要确认广告承诺与他们将从您的应用获得的内容是否一致,这使他们对商店列表元素更敏感。

使用 Google Play 商店实验进行 A/B 测试时,不会按流量来源过滤用户。

由于在将用户分配到 A/B 测试的不同变体之前没有对用户进行区分,Google Play 商店实验很可能会导致不同测试样本的组成差异很大,因此会导致与您的不同变体无关的显著转化率差异。

另一个问题是季节性对商店动态的影响,导致测试样本的表现每天都有波动。虽然这超出了您的控制范围,但在进行 A/B 测试时可以考虑这些参数:

- 将测试运行至少 7 天以减少每周模式的影响。虽然 Google 推荐这种做法,但他们的平台通常在几天内就提供 A/B 测试结果。然而,许多开发者注意到,将测试延长几天有时会显著改变结果,甚至导致测试获胜者发生逆转。

- 不要提前对季节性活动的创意进行 A/B 测试,因为用户还没有为该活动做准备。要么在活动开始时进行测试,要么直接应用新的创意并进行前后转化分析。

统计显著性与统计效力的区别

由于其背后的统计模型,理解 Google Play 商店实验和 A/B 测试具有挑战性。A/B 测试需要确定变体 A 和变体 B 结果之间的显著差异。它还应该表明正确检测真实差异(避免假阴性)和错误地得出存在差异的结论(避免假阳性)的可能性。

Google Play 商店实验都依赖于一个称为90% 置信区间的统计模型,这已经有两个主要缺点:

- 显著性水平低于大多数 A/B 测试中使用的 95% 置信区间标准

- Play 商店实验没有提供关于不同测试可靠性的明确数据。这可能会让您认为所有测试都有相同的可能性导致预测结果,而实际上,有些测试比其他测试更可靠。

实验的统计效力取决于样本大小。更大的样本可以降低假阳性的风险,并增加检测到小幅转化改进的可能性。

运行 A/B/B 测试以标记假阳性结果

在确定了 Google Play 实验给我们带来假阳性结果的可能原因后,我们的团队试图思考如何限制遇到这些问题的风险,同时提高从测试结果中判断结果是否为假阳性的可能性。

我们的结论是:

- 保持所有测试运行至少 7 天对于限制每周季节性的潜在误导结果至关重要。确保足够大的样本量以提高所有测试的统计效力也很重要。

- ASO 从业者不应该在营销团队运行 UA 活动时避免运行测试。但他们需要确保每个营销渠道的流量分配在整个测试期间保持稳定。

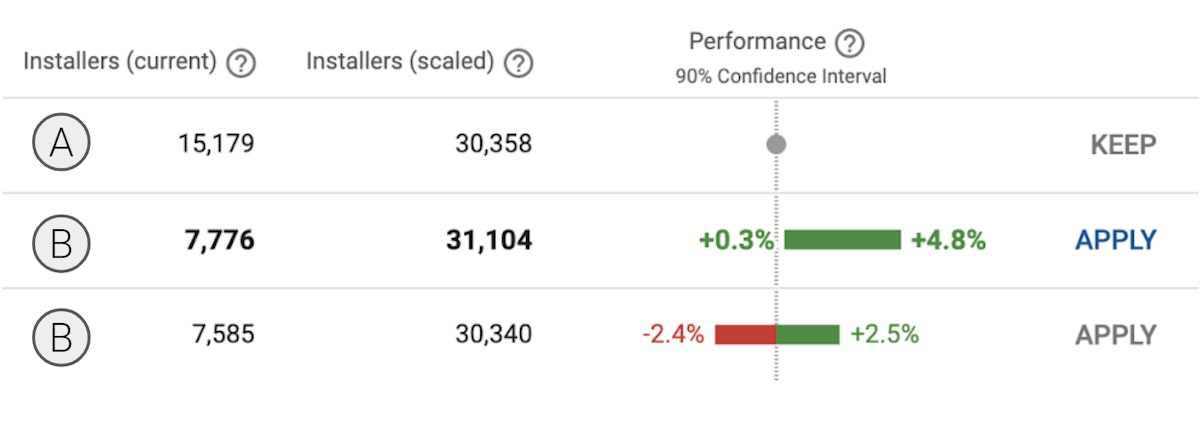

- 在测试中创建两个相同的 B 变体(实际上是设计 A/B/B 测试而不是 A/B 测试)将有助于评估结果是真实的还是假阳性。如果两个 B 样本提供类似的结果,这些可能是真阳性。相反,如果它们有不同的结果,其中一个可能是假阳性。

- 这种结构的一个结果是,样本应该分别获得 33.34%、33.33% 和 33.33% 的流量,且不应向测试添加其他(C)变体。

通过第一个和第二个 B 样本之间的显著差异结果,A/B/B 测试可以标记可疑结果,其中至少有一个结果是假阳性。

这种新协议的主要优势是它在一周内评估测试可靠性。相比之下,一种流行的方法是在第一周进行 A/B 测试,然后在第二周进行 B/A 测试以确认初始结果。这两种方法都能有效预防假阳性。但是A/B/B 测试结构减少了采取行动所需的时间,并确保”确认”样本同时进行测试,避免潜在的季节性偏差。

评估 A/B/B 测试方法的影响

在了解了统计学知识后,我们关于 A/B/B 测试的下一个目标将是尝试评估它们对 ASO 从业者的真实影响,这就是为什么我们呼吁所有愿意的读者用他们的应用尝试这种方法并与 AppTweak 分享一些结果,这样我们希望能在后续文章中与您分享 A/B/B 测试的真实影响,特别是它们检测到假阳性结果的频率,或者它们不足以检测到假阳性的频率。

我们希望从您那里获得的每个测试信息包括:

- 应用名称(可选)

- 应用类别

- 测试的商店列表(全球 / en-us 默认 / en-uk / es-spain / …)

- 开始和结束日期

- 您测试了什么类型的变体?

- 应用的流量分配

- 每个变体的安装者数量

- 置信区间的下限

- 置信区间的上限

- 对于应用的变体,测试后一周与测试前一周之间的转化提升

您可以在这里找到分享测试结果的模板。这些数据将由 AppTweak 保密,仅用于汇总关于 A/B/B 测试方法的统计数据。

如果您愿意分享一些测试结果或对 A/B/B 方法有疑问,我们也邀请您通过我们的网站、电子邮件、社交媒体或 ASO Stack slack 频道联系我们的团队。

Oriane Ineza

Oriane Ineza

Micah Motta

Micah Motta