Google Play에서 A/B 테스트 신뢰성 향상

이 글은 2020년 5월 13일 ASO 컨퍼런스 온라인에서 발표되었습니다.

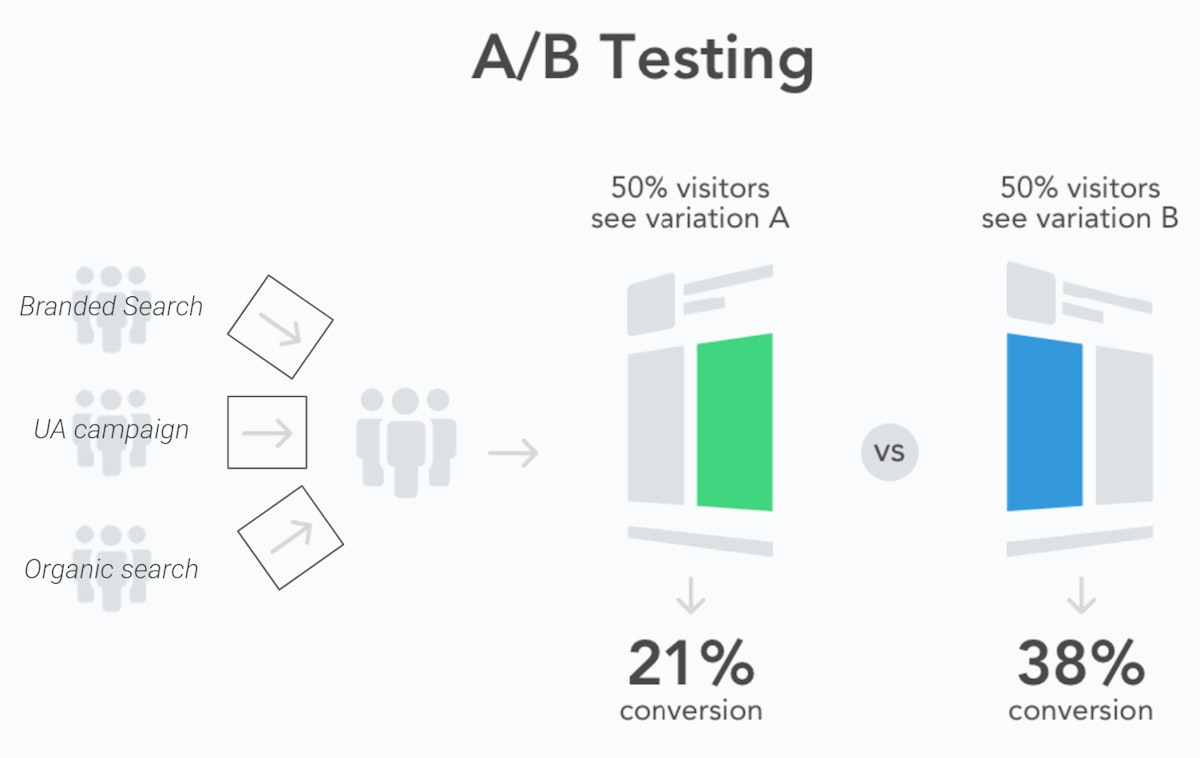

A/B 테스트는 모바일 마케팅의 표준 관행이 되었으며, ASO도 예외는 아닙니다. 원칙은 간단합니다:

- 잠재 고객을 다양한 샘플로 나누십시오

- 그들에게 다른 변형들을 보여주십시오 (예: 다른 스크린샷 세트)

- 각 변형의 성과를 측정하여 개인적인 선호도보다는 데이터에 기반하여 어떤 것을 사용할지 결정하십시오.

문제는 테스트 결과는 테스트 자체만큼만 신뢰할 수 있다는 것입니다. Google Play는 네이티브 환경에서 테스트를 실행하는 것과 같은 몇 가지 주요 이점이 있지만, 많은 ASO 실무자들은 우승 변형을 100% 사용자에게 적용한 후에도 실제로 발생하지 않은 전환율 상승을 해당 도구가 예측하는 것을 보았습니다.

Google Play A/B 테스트의 “통계적 노이즈”

Google Play 결과에서 오탐의 주요 원인 중 하나는 테스트 샘플이 구성되는 방식입니다. Google Play Store Experiments 결과에서 데이터 분석이 부족하다는 것은 Google의 A/B 테스트 도구가 다른 유형의 사용자를 구별하지 못할 수 있음을 의미합니다. 귀하의 앱 스토어 페이지를 방문하는 사용자들은 다양한 의도를 가지고 있기 때문에 이는 테스트 샘플의 전환율에 상당한 불균형을 초래할 수 있습니다:

- 귀하의 브랜드를 검색하는 사용자들은 높은 인지도 때문에 앱을 빠르게 다운로드할 가능성이 높습니다.

- 광고 캠페인 또는 일반 검색을 통해 유입된 사용자들은 광고의 약속이 앱에서 얻게 될 것과 일치하는지 확인을 구할 수 있으며, 이는 그들을 스토어 목록 요소에 더 민감하게 만듭니다.

Google Play Store Experiments로 A/B 테스트를 수행할 때 사용자들은 트래픽 소스에 따라 필터링되지 않습니다.

A/B 테스트의 다른 변형에 할당하기 전에 사용자를 구별하지 않음으로써, Google Play Store Experiments는 다른 테스트 샘플이 상당히 다르게 구성되는 결과를 초래할 가능성이 높으며, 이는 귀하의 다른 변형들과는 아무런 관련이 없는 전환율의 상당한 차이로 이어집니다.

또 다른 우려는 계절성이 스토어 역학에 미치는 영향으로, 테스트 샘플의 성능에 매일 변동을 일으킵니다. 이는 귀하의 통제 범위를 벗어나지만, A/B 테스트를 수행할 때 다음 매개변수들을 고려할 수 있습니다:

- 주간 패턴의 영향을 줄이기 위해 최소 7일 동안 테스트를 실행하십시오. Google은 이 관행을 권장하지만, 그들의 플랫폼은 종종 며칠 내에 A/B 테스트 결과를 제공합니다. 그러나 많은 개발자들은 테스트를 며칠 더 연장하면 때때로 결과가 크게 달라질 수 있으며, 심지어 테스트 우승자가 뒤바뀌는 경우도 있다는 것을 알아차렸습니다.

- 사용자들은 아직 해당 이벤트를 준비하고 있지 않으므로, 계절성 이벤트에 대한 크리에이티브를 미리 A/B 테스트하지 마십시오. 이벤트 시작 시 테스트하거나, 단순히 새로운 크리에이티브를 즉시 적용하고 사전/사후 전환 분석을 수행하십시오.

휴가 시즌에 대한 저희의 사례 연구를 통해 앱 계절성 트렌드에 대해 더 알아보십시오

통계적 유의성 & 통계적 검정력의 차이점

Google Play Store Experiments 및 A/B 테스트를 이해하는 것은 그 뒤에 있는 통계 모델 때문에 어렵습니다. A/B 테스트는 변형 A와 변형 B 결과 간의 유의미한 차이를 결정해야 합니다. 또한 실제 차이를 올바르게 감지할 가능성(오류 음성 방지)과 차이가 없을 때 차이가 있다고 잘못 결론 내리는 것(오류 양성 방지)을 나타내야 합니다.

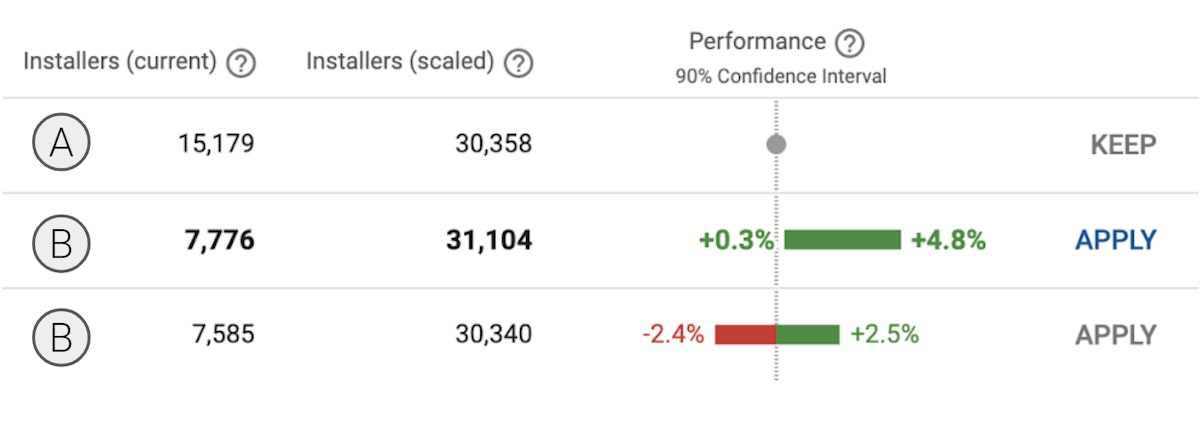

Google Play Store Experiments는 모두 90% 신뢰 구간이라고 불리는 통계 모델에 의존하며, 이는 이미 두 가지 주요 단점을 가지고 있습니다:

- 유의 수준이 대부분의 A/B 테스트에서 사용되는 95% 신뢰 구간의 표준보다 낮습니다.

- Play Store Experiments는 다양한 테스트가 얼마나 신뢰할 수 있는지에 대한 명확한 데이터를 제공하지 않습니다. 이는 사실은 일부 테스트가 다른 테스트보다 더 신뢰할 수 있는데도 불구하고, 모든 테스트가 예측된 결과로 이어질 가능성이 동일하다고 믿게 만들 수 있습니다.

실험의 통계적 검정력은 샘플 크기에 따라 달라집니다. 더 큰 샘플은 오탐의 위험을 낮추고 전환율의 작은 개선을 감지할 가능성을 높입니다.

오탐 결과를 표시하기 위한 A/B/B 테스트 실행

Google Play Experiments가 종종 오탐 결과를 제공하는 이유에 대한 유력한 용의자들을 격리한 후, 저희 팀은 그들을 만날 위험을 어떻게 제한할 수 있을지, 그리고 테스트 결과로부터 이미 저희 결과가 오탐일 가능성이 얼마나 되는지 알 수 있는 기회를 개선할 수 있을지에 대해 고민했습니다.

저희의 결론은 다음과 같습니다:

- 주간 계절성으로 인한 잠재적인 오해의 소지가 있는 결과를 제한하기 위해 모든 테스트를 최소 7일 동안 실행하는 것이 중요합니다. 모든 테스트의 통계적 검정력을 높일 수 있는 충분한 샘플 크기를 확보하는 것이 중요합니다.

- ASO 실무자들은 마케팅 팀이 UA 캠페인을 실행하는 동안에도 테스트 실행을 주저해서는 안 됩니다. 그러나 그들은 각 마케팅 채널 간의 트래픽 분할이 전체 테스트 기간 동안 안정적으로 유지되도록 해야 합니다.

- 테스트에서 동일한 B 변형 두 개를 생성하는 것(사실상 A/B 테스트가 아닌 A/B/B 테스트를 설계하는 것)은 결과가 참 양성일지 오탐일지 평가하는 데 도움이 될 것입니다. 두 B 샘플 모두 유사한 결과를 제공한다면, 이는 참 양성일 가능성이 높습니다. 반면에, 결과가 다르다면 둘 중 하나는 오탐일 가능성이 높습니다.

- 이 구조의 결과는 샘플은 각각 33.34%, 33.33%, 33.33%의 트래픽을 가져야 하며, 다른 (C) 변형은 테스트에 추가되어서는 안 된다는 것입니다.

1차 및 2차 B 샘플 간의 결과가 매우 다를 경우, A/B/B 테스트는 두 결과 중 적어도 하나가 오탐인 의심스러운 결과를 표시할 수 있습니다.

이 새로운 프로토콜의 주요 장점은 일주일 이내에 테스트 신뢰성을 평가한다는 것입니다. 대조적으로, 일반적인 방법은 첫 주에 A/B 테스트를 수행하고 두 번째 주에 B/A 테스트를 수행하여 초기 결과를 확인하는 것입니다. 두 접근 방식 모두 오탐을 방지하는 데 효과적입니다. 그러나 A/B/B 테스트 구조는 조치에 필요한 시간을 단축하고 “확인” 샘플이 동시에 테스트되도록 하여 잠재적인 계절성 편향을 피할 수 있습니다.

A/B/B 테스트 방법의 영향 평가

통계에 대해 스스로 학습한 후, A/B/B 테스트에 대한 저희의 다음 목표는 ASO 실무자들에게 미칠 수 있는 실제 영향을 평가하는 것입니다. 이것이 바로 저희가 모든 독자들에게 이 방법을 자신의 앱에 시도하고 AppTweak과 결과를 공유해 줄 것을 요청하는 이유이며, 그래서 저희는 나중에 다른 글에서 A/B/B 테스트의 실제 영향, 특히 오탐 결과를 얼마나 자주 감지했는지 또는 감지하기에 충분하지 않았던 경우가 얼마나 되는지를 여러분과 공유할 수 있기를 바랍니다.

각 테스트에 대해 저희가 귀하로부터 얻고자 하는 정보는 다음과 같습니다:

- 앱 이름 (선택 사항)

- 앱 카테고리

- 테스트의 스토어 목록 (글로벌 / en-us 기본 / en-uk / es-spain / …)

- 시작 & 종료 날짜

- 어떤 변형 유형을 테스트하셨습니까?

- 적용된 트래픽 분할

- 변형별 설치자 수

- 신뢰 구간의 하한

- 신뢰 구간의 상한

- 적용된 변형의 경우, 테스트 후 주와 이전 주 사이의 전환율 상승

테스트 결과를 공유하기 위한 템플릿은 여기에서 찾을 수 있습니다. 이 데이터는 AppTweak에 의해 기밀로 유지되며 A/B/B 테스트 방법에 대한 통계를 집계하는 데만 사용됩니다.

테스트 결과를 공유하거나 A/B/B 방법에 대해 질문이 있으시면, 저희 웹사이트, 이메일, 소셜 미디어 또는 ASO Stack 슬랙 채널을 통해 저희 팀에 연락해 주시기를 권유합니다.

Oriane Ineza

Oriane Ineza

Micah Motta

Micah Motta